Im Silicon Valley verschiebt sich die Macht: junge Talente übernehmen Verantwortung, während etablierte Strukturen wanken und KI-Projekte unter Druck geraten.

Bei xAI, dem Unternehmen hinter Grok, zeigt sich ein radikaler Kurswechsel. Nach massiven Einschnitten trägt plötzlich ein 20-Jähriger Verantwortung für die Neuaufstellung eines Teams, das eine milliardenschwere Technologie antreibt.

Was hinter der personalentscheidung steckt

xAI beschäftigte bis vor Kurzem rund 1.500 Menschen. Anfang September trennte sich das Unternehmen von etwa 500 Beschäftigten. In der Woche ab dem 15. September folgten rund 100 weitere Kündigungen. Die Belegschaft liegt nun bei ungefähr 900 Personen.

Die Kürzungen trafen vor allem Datenannotatorinnen und -annotatoren. Sie trainieren große Sprachmodelle, indem sie Antworten bewerten, Beispiele erstellen und Modelle korrigieren. Diese Arbeit bildet die Grundlage für Systeme wie Grok.

Rund 600 Entlassungen binnen weniger Wochen: xAI schrumpft von etwa 1.500 auf circa 900 Beschäftigte.

Gleichzeitig setzt Elon Musk auf eine ungewöhnliche Personalie: Diego Pasini, 20 Jahre alt, übernimmt eine Schlüsselrolle beim Reorganisieren und Anleiten des verbliebenen Teams. Ziel ist es, Produktivität zu erhöhen und die Ausbildung der technischen Mannschaft zu bündeln.

Wer ist Diego Pasini

Pasini studierte laut öffentlichen Profilen Informatik und Wirtschaft an der University of Pennsylvania. Sein Status ist beurlaubt. 2024 erhielt er ein Stipendium der Investmentfirma Contrary, die in technologiegetriebene Startups investiert.

Er interessiert sich für Robotik, Hardtech und deren Einsatz in Landwirtschaft und Transport. An der University of Pennsylvania arbeitete er nach eigenen Angaben in der Agricultural Robotics Group des GRASP-Labors mit.

Ein 20-jähriger mit Robotik-Background und Startup-Fokus soll ein KI-team neu aufstellen und schulen.

Zum Start seiner Tätigkeit stellte Pasini intern Stabilität in Aussicht. Kurz darauf strich xAI weitere Stellen. Das signalisiert, wie eng Restrukturierung und operative Ziele verzahnt sind.

Warum xAI so viele datenjobs streicht

Datenannotation kostet viel Geld und wächst kaum linear mit dem Modellfortschritt. Unternehmen reduzieren diese Ausgaben, wenn sie automatisierte Feedbackschleifen testen oder den Fokus auf „High-Impact“-Daten legen. xAI folgt diesem Muster und verschiebt Ressourcen näher an Modellarchitektur, Evaluierung und Produktintegration.

Was datenannotatoren eigentlich leisten

- Bewerten und ranken Modellantworten für Feintuning und Reinforcement Learning aus menschlichem Feedback (RLHF).

- Formulieren hochwertige Prompts und Gegenbeispiele, um Fehlverhalten zu reduzieren.

- Erstellen Prüfsets für Sicherheit, Halluzinationen, Bias und Faktenlage.

Weniger Annotatorinnen und Annotatoren bedeutet nicht zwangsläufig schlechtere Qualität. Die Wirkung hängt davon ab, wie gut xAI aktive Datenauswahl, synthetische Daten und Expertinnenbewertungen kombiniert.

Zahlen, daten, zeitleiste

| Monat | Belegschaft | Maßnahme |

|---|---|---|

| Bis August | ~1.500 | Vollbetrieb bei Grok |

| Anfang September | ~1.000 | ~500 Entlassungen, Fokuswechsel bei Training |

| Woche 15. September | ~900 | Weitere ~100 Entlassungen |

Was das für Grok-nutzerinnen und nutzer bedeutet

Grok steht im Markt gegen ChatGPT, Claude und Gemini. Ein geschrumpftes Team kann schneller entscheiden, riskiert aber Engpässe in Support und Qualitätssicherung. Nutzerinnen und Nutzer sollten kurzfristig mit häufigeren Modellupdates rechnen, die Funktionen verschieben oder Antworten spürbar verändern.

Woran du erkennst, wohin es geht

- Antwortqualität: Bleiben Faktenkonsistenz und Stil stabil, trotz häufigerer Releases.

- Tempo: Kürzere Feedbackzyklen deuten auf eine aggressive Roadmap.

- Transparenz: Klare Changelogs und Safety-Notizen sprechen für gereifte Prozesse.

Generation z im maschinenraum

Pasini ist kein Einzelfall. Laut Berichten setzt Musk auch auf Luke Farritor (24) und Edward Coristine (19) sowie weitere junge Führungskräfte. Das passt zu einem Trend: Hochskalierende KI-Projekte bevorzugen Menschen, die schnell prototypisieren, scharfe Prioritäten setzen und lange Arbeitszyklen akzeptieren.

Diese Wette birgt Chancen und Risiken. Frische Perspektiven können festgefahrene Abläufe aufbrechen. Gleichzeitig fehlen oft Industrieerfahrung, regulatorisches Gespür und Führungsroutine.

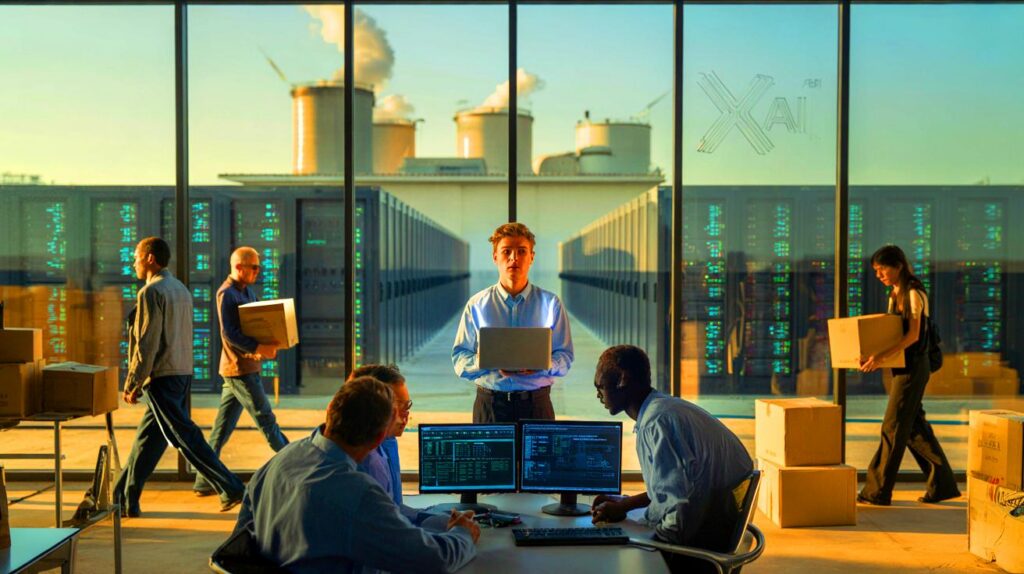

Energiefrage und genehmigungen

xAI treibt Rechenzentren an, die zeitweise mit dutzenden Gasturbinen liefen. Eine Umweltorganisation erhob Vorwürfe zu Genehmigungen. xAI und Behörden sprechen von einer temporären Lösung. Der Vorgang zeigt, wie knapp Kapazitäten für KI-Strom und Kühlung sind und wie schnell Betreiber an rechtliche Grenzen stoßen.

Für Nutzerinnen und Nutzer kann das bedeuten: gelegentliche Drosselung, Wartungsfenster oder Performance-Sprünge, wenn neue Infrastruktur ans Netz geht. Für Anwohnerinnen und Anwohner zählen Emissionen, Lärm und Genehmigungspflichten.

Wie ein 20-jähriger ein ki-team tatsächlich schulen kann

Die Aufgabe wirkt groß, lässt sich aber strukturieren. Kern ist die Ausrichtung auf messbare Qualität und Produktnutzung. Ein mögliches Vorgehen umfasst drei Takte.

- Diagnose: Lückenanalyse bei Daten, Evaluationssets und Incident-Response für fehlerhafte Antworten.

- Taktik: Wenige, harte Metriken (z. B. Code-Assist, Faktengenauigkeit, Sicherheit) und klare Owner pro Metrik.

- Delivery: Zweiwöchentliche Releases, A/B-Tests, schnelle Rollbacks, dokumentierte Prompts und Guardrails.

So entsteht Schulung im Fluss: weniger Folien, mehr Pairing, Live-Debugging, Postmortems und wiederholbare Playbooks. Das stärkt Teamkompetenz effizienter als klassische Trainingswochen.

Risiken, chancen und was du jetzt einplanen solltest

Risiken liegen in Qualitätsdrift, erhöhter Burn-out-Gefahr und Reibungen mit Aufsichtsbehörden. Chancen ergeben sich aus schneller Produktiteration, schlankeren Prozessen und klaren Verantwortlichkeiten.

Wer Grok beruflich nutzt, sollte kritische Workflows doppelt absichern. Halte lokale Protokolle, teste zentrale Prompts regelmäßig, und dokumentiere Modellversionen. Wer Grok testet, kann gerade jetzt ungewöhnliche Stärken oder Schwächen entdecken und Feedback einreichen, das tatsächlich Produktentscheidungen beeinflusst.

Begriff zum mitnehmen: rlhf kurz erklärt

Reinforcement Learning aus menschlichem Feedback koppelt Modellantworten mit menschlichen Bewertungen. Ein Belohnungsmodell lernt, welche Antworten bevorzugt sind. Das Hauptmodell wird dann so optimiert, dass es sich dem Belohnungsmodell anpasst. Weniger Annotatorinnen und Annotatoren erfordern präzisere Auswahl von Beispielen und zuverlässige Expertenpanels, sonst kippt die Qualität.

Licencier 500 puis ~100 de plus, surtout côté annotation RLHF… Comment Grok va-t-il garder la qualité sans assez d’évalutations humaines? Risqué, sauf s’ils ont des données synthétiques vraiment solides.

20 ans pour diriger Grok ? Audacieux.